Využití AI na počítačích s Windows 11 představuje pokrok pro pro hráče, tvůrce, streamery, studenty i běžné uživatele PC. Nabízí možnosti zásadního zvýšení produktivity a efektivity majitelům více než 100 milionů počítačů a pracovních stanic se systémem Windows, které jsou vybaveny GPU RTX.

A díky technologiím NVIDIA RTX se daří vývojářům ještě více usnadnit vývoj aplikací využívající AI. Přispějí k tomu i nové optimalizace, modely a prostředky oznámené na konferenci Microsoft Ignite.

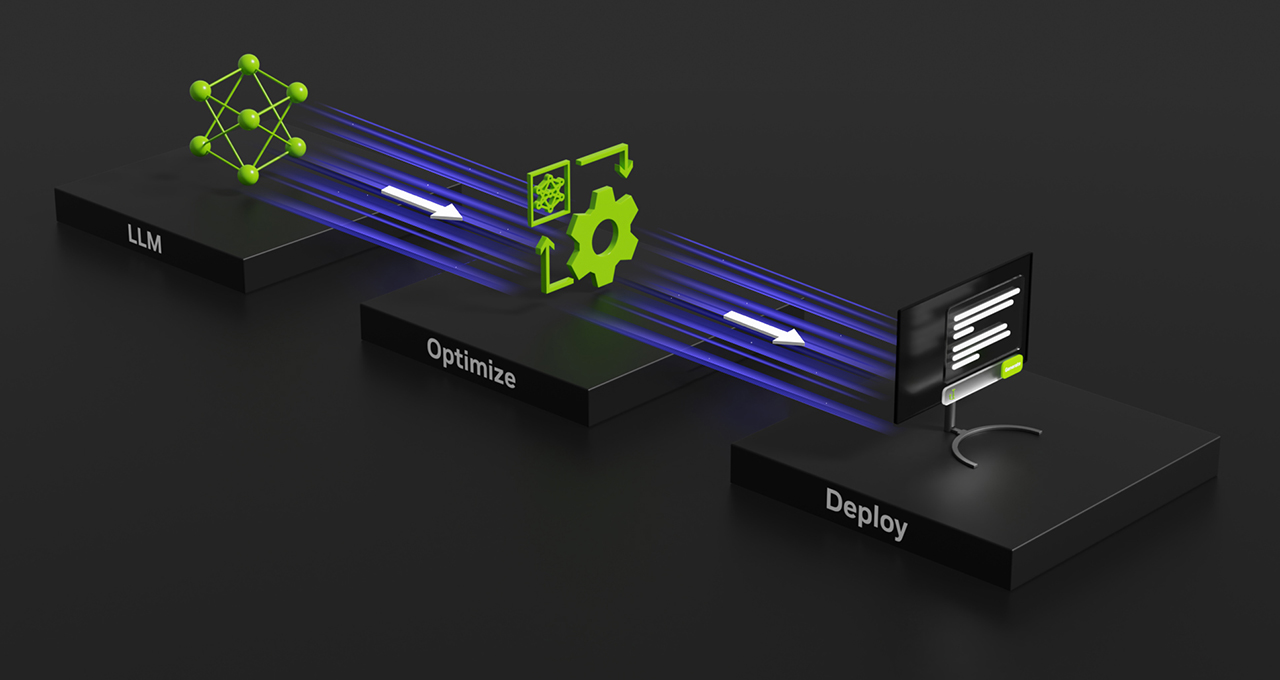

Minulý měsíc společnost NVIDIA oznámila TensorRT-LLM pro Windows, knihovnu pro akceleraci odvozování velkých jazykových modelů (LLM). Nová verze v0.6.0, která vyjde koncem tohoto měsíce, přinese až 5x vyšší výkon inference a přidá podporu dalších populárních LLM, včetně nového Mistral 7B a Nemotron-3 8B. Tyto verze bude možné provozovat na stolních PC a noteboocích s GPU GeForce RTX řady 30 nebo 40, pokud disponují alespoň 8GB VRAM.

Snazší využití AI mimo cloud

Jedním z problémů cloudových AI je nutnost nahrávání vstupních dat, což je nepraktické pro soukromá nebo proprietární data nebo pro práci s velkými soubory.

Aby NVIDIA tento problém vyřešila, umožní brzy TensorRT-LLM pro Windows nabízet podobné rozhraní API jako široce populární ChatAPI od OpenAI prostřednictvím nového wrapperu. Ten vývojářům nabídne podobný pracovní postup bez ohledu na to, zda navrhují modely a aplikace pro běh lokálně na počítači s RTX GPU nebo v cloudu. Změnou pouhého jednoho nebo dvou řádků kódu mohou nyní stovky vývojářských projektů pracujících s AI využívat výhod rychlé lokální umělé inteligence. Uživatelé mohou mít data na svých počítačích a nemusí se starat o nahrávání datových sad do cloudu.

Řada z těchto projektů a aplikací je open source, což vývojářům usnadňuje práci a otevírá nové možností. Generativní AI ve Windows 11 díky tomu může být populárnější.

Wrapper bude pracovat s jakýmkoli LLM, který byl optimalizován pro TensorRT-LLM (například Llama 2, Mistral a NV LLM), a je zveřejněn jako referenční projekt na GitHubu spolu s dalšími vývojářskými zdroji pro práci s LLM na RTX.

Vývojáři nyní mohou využívat nejmodernější AI modely a nasazovat je pomocí univerzálního API. Společnosti NVIDIA a Microsoft také spolupracují na možnosti akcelerovat model Llama pomocí RTX prostřednictvím rozhraní DirectML API.